Wie lange wirkt eine Dunkelflaute wirklich?

Grundlegender ist eine andere Herausforderung, nämlich jene, mit einem System aus 100 Prozent erneuerbarer Stromversorgung die Versorgungssicherheit zu gewährleisten. Hier stellt die sogenannte Dunkelflaute ein Problem dar. Die meisten Studien kommen zu dem Schluss, dass diese kein Problem sei, dauert sie doch maximal zwei Wochen. Doch stimmt das? Wahrscheinlich nicht, wie eine neue Studie von Oliver Ruhnau und Staffan Qvist vorrechnet. Demnach muss ein viel längerer Zeitraum überbrückt werden. Mit Staffan Qvist spreche ich dazu auch am Sonntag.

Hier die Highlights (Übersetzung von mir):

- „Die Machbarkeit einer 100 % erneuerbaren Stromversorgung ist weiterhin ein kontroverses Thema. Da ein vollständig erneuerbares Stromsystem in den meisten Ländern stark auf Wind- und Sonnenenergie angewiesen ist, ist ein häufig diskutierter Aspekt die Systemzuverlässigkeit bei Ereignissen mit geringer Verfügbarkeit dieser variablen Energiequellen. Am Beispiel Deutschlands haben solche Extremereignisse auch öffentliche und politische Aufmerksamkeit erhalten, und der deutsche Begriff ‘Dunkelflaute’ hat es in die internationale Debatte geschafft.“ – bto: Dunkelflaute als internationaler deutscher Exportbegriff, wer hätte das gedacht?

- „Frühere Studien zu Erneuerbaren-Knappheitszeiten konzentrierten sich meist auf Windenergie. Diese Studien sind in ihren Ansätzen und Ergebnissen ähnlich. Sie definieren einen Schwellenwert, unterhalb dessen die Windleistung oder Windgeschwindigkeit als „gering“ gilt. (…) Die maximale Dauer von Schwachwindereignissen, die in diesen Studien identifiziert wurden, beträgt 4–10 Tage.“ – bto: weshalb man zu der Aussage kommt, dass es kein so großes Problem sei, diesen Zeitraum zu überbrücken.

- „Weitere Zeitreihenanalysen ergaben, dass Schwachwindereignisse aufgrund der geografischen Glättung ausgeprägter sind, wenn man sich auf einzelne Orte konzentriert, und weniger extrem werden, wenn man den geografischen Umfang auf die kontinentale Ebene ausdehnt.“ – bto: Kein Wunder, irgendwo bläst der Wind immer, mag man sagen.

- „Schließlich erweiterten Raynaud et al. den Anwendungsbereich auf Solarenergie, Wasserkraft und Last, um ‘Energiedürren’ zu untersuchen, definiert als Perioden, in denen erneuerbare Energien weniger als 20 % der Nachfrage decken. Sie fanden heraus, dass ein Mix aus erneuerbaren Energien die Dauer von Energiedürren im Vergleich zu einzelnen Energiequellen um den Faktor zwei oder mehr reduziert und dass die Dauer von Energiedürren in Szenarien mit 100 % erneuerbaren Energien 2 Tage nicht überschreiten wird.“ – bto: Das sind genau die Aussagen, auf denen unsere gesamte „Strategie“ der Energieerzeugung basiert. Es ist also kein Problem.

- „Die Gegenüberstellung der Ergebnisse aus Zeitreihenanalysen und Optimierungsmodellen erscheint aus drei Gründen interessant. Erstens deuten die größeren Speichervolumina in den Optimierungsstudien darauf hin, dass der Speicherbedarf nicht direkt aus der Länge der schlimmsten Dunkelflaute, die durch Zeitreihenanalysen identifiziert wurde, abgeleitet werden kann. Zweitens erscheinen die größeren Speichervolumen in den Optimierungsstudien kontraintuitiv, da diese Studien Flexibilitätsoptionen über die Speicherung hinaus beinhalten, die in den Zeitreihenanalysen nicht berücksichtigt werden. Drittens basieren die obigen Optimierungsmodelle auf 1–3 Wetterjahren, und es bleibt unklar, ob diese Jahre die schlimmsten Dunkelflaute-Perioden enthalten, die durch Zeitreihenanalysen auf der Grundlage von Datensätzen mit mehreren Jahrzehnten identifiziert wurden.“ – bto: Klartext. – Die bisherigen Studien erfassen nicht die wirklichen Extremereignisse und die Annahmen bezüglich Speicher und alternative Quellen sind nicht immer konsistent.

- Deshalb diese Analyse: „Diese Studie schließt die Lücke zwischen Zeitreihenanalysen von Extremereignissen und Optimierungsmodellen. Zum einen analysieren wir 35 Jahre Erneuerbare- und Last-Zeitreihen, um die Dunkelflaute hinsichtlich des über einen bestimmten Zeitraum anfallenden maximalen Energiedefizits zu charakterisieren. Wir berechnen auch die erforderliche Speicherenergiekapazität mit einem stilisierten Kostenoptimierungsmodell unter Verwendung der gleichen Eingangszeitreihen.“ – bto: Es ist also die Analyse mit dem tatsächlichen Risiko und nicht einem zu optimistisch berechneten.

- „Unsere Ergebnisse deuten darauf hin, dass sowohl Zeitreihenanalysen als auch Optimierungsmodelle häufig mit Vereinfachungen ausgestattet sind, die zu einer Unterschätzung der Speicheranforderungen führen können. Bei Zeitreihenanalysen erscheint es unzureichend, kurze Perioden mit extremer Knappheit zu betrachten, da diese von anderen Knappheitsperioden umgeben sein können, die gemeinsam den Speicherbedarf definieren. Bei Optimierungsmodellen erscheint die Analyse einzelner Jahre unzureichend, da diese nicht unbedingt Extremereignisse beinhalten.“ – bto: Wir haben also mehr Extremereignisse UND diese können nacheinander erfolgen, was eben zu längerer Unterdeckung der Erzeugung führt.

Konkret sieht das dann so aus:

- „Wir verwenden ein Optimierungsmodell, um das kostengünstigste 100% erneuerbare Stromsystem für das Beispiel Deutschland zu finden. Das Modell entscheidet über Investitionen in variable erneuerbare Generatoren und Stromspeicherung in Batterien und über Wasserstoff. Gleichzeitig wird der Speichereinsatz unter Berücksichtigung bestehender Bioenergie und Wasserkraft (inkl. Pumpspeicher) optimiert. Das Optimierungsproblem erstreckt sich über 35 aufeinanderfolgende Jahre auf stündlicher Basis. Für jede Stunde muss die Primärstromversorgung aus erneuerbaren Energien plus Speicherentladung minus Speicherladung und Abregelung gleich der Last auf Landesebene sein.“ – bto: Es wird also zu jedem Zeitpunkt der Bedarf gedeckt – entweder durch Erzeugen oder durch Speichern/Wasserstoff.

- „Die Eigenschaften des mehrjährigen kostenoptimalen 100 % erneuerbaren deutschen Stromsystems sind in Abbildung 1 zusammengefasst. Auf der Angebotsseite sind fast 300 GW variable erneuerbare Erzeuger installiert: 92 GW Solar-PV, 94 GW Onshore-Wind und 98 GW Offshore-Wind. Bei Solar-PV und Onshore-Windkraft ist dies fast doppelt so viel wie die installierte Leistung im Jahr 2020; für die Offshore-Windkraft bedeutet dies eine Steigerung um mehr als das Zehnfache. Diese variablen Generatoren werden durch etwa 81 GW Speicherentladekapazität ergänzt, darunter größtenteils wasserstoffbefeuerte Gas- und Dampfturbinen (Kurz: GuD)-Anlagen (62 GW). Perspektivisch entspricht die installierte Kapazität der GuD-Anlage fast der Durchschnittslast, während die Gesamtentladekapazität 77 % der Spitzenlast (105 GW) liefern kann. Die Ladeleistung des Speichers liegt mit rund 72 GW etwas unter der Entladeleistung. Bis zu 161 GW erneuerbare Überschusserzeugung werden abgeregelt, weil dies wirtschaftlicher ist als der Bau weiterer Speicher.“ – bto: Das klingt zunächst nicht nach einem besonders kosteneffizienten System, weil erhebliche Überkapazitäten aufgebaut werden müssen.

- „Die Speicherenergiekapazität, die im Fokus der vorliegenden Arbeit steht, beträgt 56 TWh. Der größte Teil davon entfällt auf Wasserstoffspeicherung (54,8 TWh), während bestehende Pumpspeicherkraftwerke 1,3 TWh und Batterien nur 59 GWh (0,059 TWh) beitragen. Unter Berücksichtigung der Entladeeffizienz entspricht das Speichervolumen einer maximalen Bereitstellung von 36 TWh Strom. Das sind etwa 7 % der Jahresbelastung oder 24 d der durchschnittlichen Belastung – viel länger als das, was bisherige Zeitreihenanalysen aufgrund ihrer Definition einer Dunkelflaute finden. Die Speicherdauer beträgt 23 d für Wasserstoff, 6 d für Pumpspeicherkraftwerke und 6 h für Batterien.“ – bto: Wir brauchen also deutlich mehr Speicher, um das System abzusichern.

- „Die gesamte Primärversorgung aus erneuerbaren Quellen beträgt etwa 700 TWh, was etwa 130 % der modellierten Jahreslast entspricht (…) Nur 65 % der Primärenergieversorgung dienen direkt der Last (455 TWh), während 23 % in Speicher geladen werden (160 TWh) und 12 % abgeregelt werden (84 TWh). Die Speicherentladung beträgt 92 TWh (17 % der Last).“ – bto: Das unterstreicht erneut, welche gigantischen Überkapazitäten geschaffen werden müssen.

Doch wie lange brauchen wir wirklich Speicher?

- „Da frühere Zeitreihenanalysen Knappheitsereignisse mit einer Dauer von bis zu 10 d identifizierten, konzentrieren wir uns zunächst auf den knappsten Zeitraum von 10 d. Wir finden, dass dieser Zeitraum im Dezember 2007 liegt. Das Energiedefizit in diesem Zeitraum beträgt 12,4 TWh (8 d durchschnittliche Last), was nur ein Drittel der 36 TWh Strom ist, die der kostenoptimale Speicher liefern kann. (Allerdings zeigt eine genauere Analyse), dass auch die 2 d vor und der erste Tag nach der schlechtesten 10 d-Periode knapp an Energie sind, obwohl die Versorgung nicht so knapp ist wie während der 10 d. Daher ist mit einem Speicherbedarf von mehr als 10 d zu rechnen.“ – bto: Es gab also davor und danach kürzere Dunkelflauten, was bedeutet, dass die Speicher nicht voll waren, als die zehntägige Dunkelflaute begann und praktisch leer waren (nach den zehn Tagen), als eine erneute Dunkelflaute ansetzte. Wir müssen also den Speicherstand berücksichtigen, wenn wir auf die benötigte Menge kommen wollen.

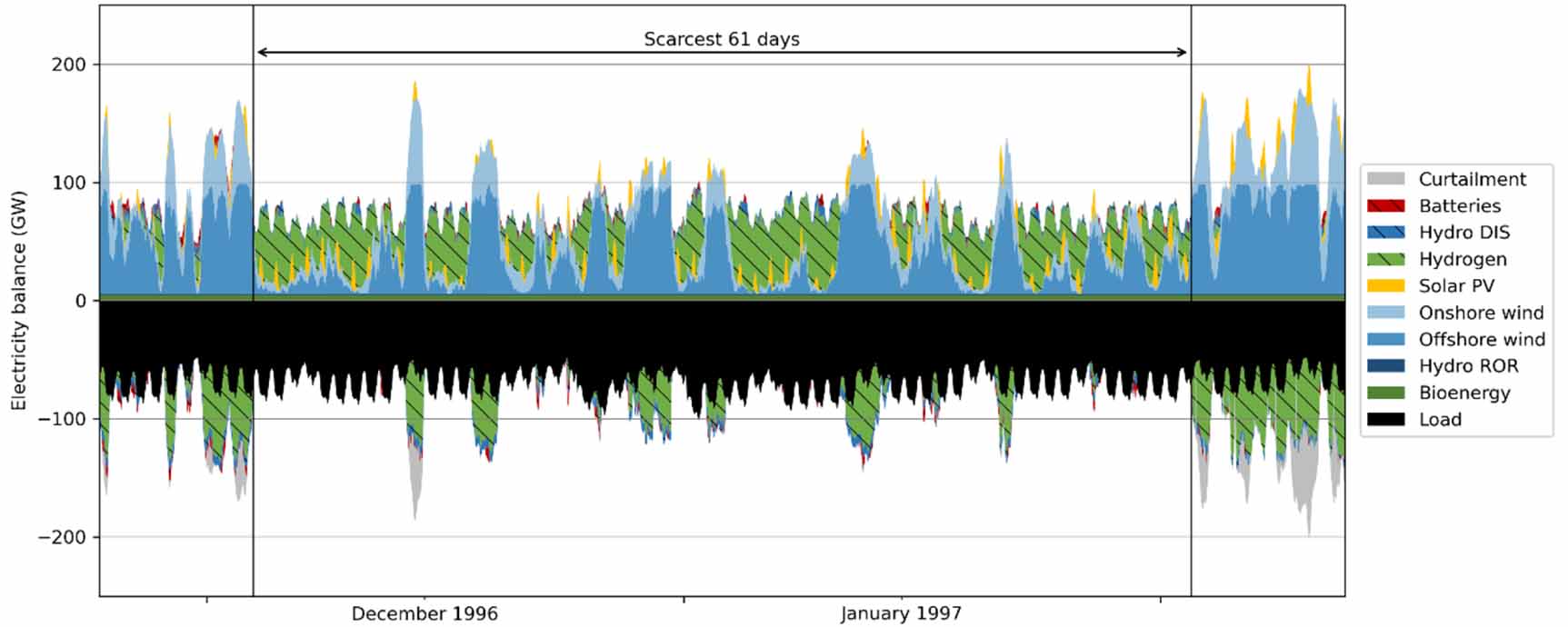

- Ergebnis einer solchen Betrachtung: „Das gesamte maximale Energiedefizit beträgt 27 TWh (18 d durchschnittliche Last) und summiert sich über 61 d (knapp 9 Wochen). Diese 61 d umfassen nicht eine Periode mit konstant niedrigem Angebot, sondern mehrere knappe Perioden hintereinander, unterbrochen von kurzen Perioden mit Energieüberschuss (Abbildung 4).“ – bto: Angesichts der Bedeutung der Energiesicherheit sind das ernst zu nehmende Berechnungen!

Abb: Längste Lücke

Quelle: Ruhnau/Qvist

- Damit noch nicht genug: „Berücksichtigt man jedoch sowohl Speicherverluste als auch Ladebeschränkungen, verlängert sich der schlechteste Zeitraum von 61 auf 84 Tage (12 Wochen, fast 3 Monate).“ – bto: Das sind ganz andere Werte, als man sonst diskutiert.

- Und jetzt kommt noch eine weitere ‘revolutionäre’ Betrachtung. Statt nur auf Kalenderjahre zu blicken, werden Mehrjahresperioden betrachtet: „Bei der mehrjährigen Optimierung haben wir festgestellt, dass der Speicherbedarf durch eine Winterperiode definiert wird, die den Kalenderjahreswechsel kreuzt. (…) Bemerkenswerterweise unterschätzt die einjährige Optimierung den langfristigen Speicherbedarf systematisch: Das durchschnittliche einjährige Wasserstoffspeichervolumen ist nur halb so groß wie bei der mehrjährigen Optimierung. Das einzige Jahr, das den mehrjährigen Speicherbedarf nahezu erfüllt, ist der 12-Monats-Zeitraum von Juli 1996 bis Juni 1997 – der den zuvor ermittelten knappsten Zeitraum umfasst. (…) Die einjährige Optimierung neigt auch dazu, die Kosten zu unterschätzen, wobei 1996–1997 der mehrjährigen Schätzung am nächsten kommt.“ – bto: Die Studien, die uns seit Jahren vorgetragen werden, betrachten also Kalenderjahre und vergessen die Notwendigkeit, Speicher zu füllen, bevor es wieder eine Flaute gibt. Dies ist aber die Basis, auf der wir Entscheidungen zur Zukunft unseres Wohlstands treffen. Fatal!

Fazit der Autoren:

„Basierend auf unseren Ergebnissen kommen wir zu dem Schluss, dass die Konzentration auf kurze Extremereignisse oder einzelne Jahre irreführend sein kann, wenn die Menge an Speicher benötigt wird, die in 100 % erneuerbaren Stromsystemen benötigt wird. Stattdessen wird für das Beispiel Deutschland der Speicherbedarf durch einen 12-wöchigen oder längeren Zeitraum intermittierender Knappheit definiert, und die Systemplanung auf der Grundlage durchschnittlicher Jahre unterschätzt den Speicherbedarf und die Systemkosten erheblich.“

Die Autoren sprechen in der Studie die Atomkraft nicht an. Sie betonen stattdessen am Ende: „Trotz dieser wirtschaftlichen Herausforderungen und der verbleibenden technologischen Unsicherheit bei einem großflächigen Ausbau der Wasserstoffinfrastruktur erscheint die geschätzte notwendige Speicherenergiekapazität im Vergleich zur aktuellen deutschen Erdgasspeicherkapazität machbar.“

Machbar ist es, allerdings sind die Dimensionen und damit die Kosten deutlich höher und es fehlt bisher die Erkenntnis der Akteure in Politik und Wirtschaft, wie massiv die Investitionen sein müssen. Die Gefahr von Blackouts ist realistisch.